În mod logic, toate acestea implică timp, așa că am luat-o și am pregătit această postare cu principalele modificări care au fost în Google SEO în 2014-2015 și ce presupun aceste schimbări pentru noi.

Cel mai izbitor, Pagerank a murit

Este unul dintre datele care atrage cel mai mult atenția: PR -ul a înghețat, nu va fi actualizat din nou, nu va fi o valoare de luat în considerare din nou. De fapt nu este o schimbare grozavă, deoarece PR -ul a încetat să mai aibă valoare cu mult timp în urmădar o declarație oficială confirmă ceea ce mulți au spus cu mult timp în urmă: a fost o valoare moartă care nu ar trebui să mai fie luată în considerare.

Punct în favoare: Din fericire, diverse instrumente și -au creat propriii algoritmi pentru a calcula autoritatea unei adrese URL, astfel încât putem continua să folosim valorile care ne oferă Moz, Ahrefs, Alexa, etc. Este fiabilitatea acestora, este redundanța, fiabilă? Nu preadar este ceea ce avem în mâinile noastre. Chuiso.com va rămâne pentru totdeauna în PR4 😀

Puncte împotriva: Pagerank a fost un bump, dar a fost un indicator de încredere (fiind un rezultat oficial dat de Google) pentru a detecta paginile penalizate manual. Pentru a vă oferi un exemplu când am fost penalizat manual în urmă cu câteva luni (liniște, l -am depășit) PR -ul meu a scăzut la 0. Detectarea acesta a fost un indiciu frumos pe care nu îl vom mai avea.

Modificări ale algoritmilor Penguin (3.0) și Panda (4.1)

El Obiectivul principal al Panda În noua sa actualizare (4.1) este de a menține rezultatele calității în SERP -uri, deci este încă un filtru care mătura primele pagini către site -uri web cu conținut de calitate slabă sau de calitate scăzută. Procesează mult mai multe informații decât algoritmul Google convențional (cel care funcționează zilnic) și, prin urmare, este mai selectiv și mai fiabil și este adesea capabil să „detecteze„ „cassock”.

Pe de altă parte este Penguin 3.0că ne pasă foarte mult, mult mai mult. Penguin trimite rezultatele care sunt acolo în mod artificial, de exemplu toate aceste web SPAMER LINKBUILDINGTierged Link Building și altele. Penguin rulează fiecare timp „X” (fără a confunda faptul că Penguin acționează că Penguin actualizează o nouă versiune îmbunătățită), iar în procesul său mătura multe pagini care fac ca pălăria neagră să fie rușinoasă. El m -a măturat de mai multe ori și îl cunosc bine. Acest algoritm este pe cale să fie actualizat, este o chestiune de zile/săptămâni.

Cu actualizări curente (Panda) au existat modificări ușoare, dar Nimic surprinzător.

Puncte în favoare: Nu au fost actualizări foarte contondente, mai degrabă la fel ca întotdeauna. Poate că în engleză rezultatele s -au îmbunătățit foarte mult, dar în spaniolă continuăm să vedem rezultate foarte bizare în SERP -uri.

Puncte împotriva: Când actualizarea Penguin va fi un procent de webmasteri care suferă o pedeapsă parțială sau totală. Dacă ați făcut o treabă foarte bună, puteți supraviețui 100%, dar este foarte probabil să pierdeți poziții/trafic într -un proiect. Teoretic pinguin afectează mai puțin de 1% din pânze

Un algoritm mai frecvent = mai periculos

Nu ne putem îndoia: Pinguinul este eficient. De fiecare dată când trece prin SERP -uri, izbucnește multe site -uri web care s -au poziționat rapid cu Truquillos Blackwater. Singurul punct pozitiv este că Google ia foarte puțin Penguin, deoarece consumă multe resurse pentru a executa un algoritm care trebuie să îndeplinească atât de multe sarcini. Este imposibil ca un astfel de algoritm să funcționeze, de exemplu, săptămânal sau lunar.

Aici vine trucul. John Mueller El a vorbit în septembrie despre Penguin și a menționat că încearcă să fie actualizați mai repede. Deoarece? Este evident. Deoarece Penguin acționează până când acționează din nou, timpul în care oameni ca mine pot clasifica site -uri web în mai puțin de 1 lună și monetiza câteva luni înainte de a cădea. Google nu este mut și știe că aceasta este o problemă, dar nu au o soluție actuală … Sau da?

Recent, eu și mulți alți Blackhatros (oameni menționați precum Godoveryou sau Matt Woodward) am observat același lucru: costă mult mai multe site -uri de rang noi, cu domenii noi. Procedura utilizată este aceeași și nu contează că legăturile sunt de o calitate mai mare sau mai mică, pur și simplu Fără rang rapid (sau nu ca înainte, dacă ați făcut o treabă rapidă și bună).

Legăturile Durează până la 1 lună pentru a face un efect aparent Și un nou domeniu poate dura până când 2-3 luni pentru a începe Rankear… am dovedit asta cu o nișă practică în Teamplatino Și pe baza experienței altor webmasteri și se pare că este decizia pe care Google a luat -o pentru a evita atât spam -ul în intervalele de timp îndelungate în care pinguinul este absent.

Punct în favoare: Mă gândesc că domeniile expirate (care nu au fost penalizate sau maltratate) sunt opțiunea ideală pentru a evita acest proces de „ascensiune interzisă” 😎

PBN -urile au murit … sau au fost în Parranda?

Acest lucru a fost, de asemenea, foarte mediatizat, cum ar fi Pagerank. Anunță Google (și Matt Twitlea, desigur) Au dat o lovitură grea PBN (rețele de bloguri private). Îmi amintește când, în știri, poliția spune ceva similar: „Am lovit o lovitură grea pentru traficul de droguri” el el. Ei se aruncă tot anul dând lovituri dure, dar traficul de droguri nu se termină niciodată, invers, merge mai mult.

În acest caz, au existat webmasteri care s -au arătat public ca proiecte proprii au fost vânate, dar, în termeni generali, impactul a fost foarte scăzut. Ceea ce se întâmplă în practică este că Penalizează aceste site -uri web sau Desindex. Când Google funcționează aceste manual în stilul „echipelor de moarte” Ei fac ceva foarte logic: Ei caută modele și amprente; Și mai presus de toate, Googlean. Forumuri de pălărie neagră Googlean, Googlean Warriorforum, Googlean «Rețele de bloguri private», etc.

Să fim sinceri, un PBN are puțin privat din momentul în care l -ați anunțat public pe un forum sau pe un site web de servicii și este într -adevăr simplu să localizați Google URL -urile acestor site -uri web. Un adevărat PBN ar fi un Rețea privată unipersonală Că numai tu folosești și fii bine făcut, așa cum poruncește Dumnezeu. Să vedem cine prinde asta 😛

Din mâna lui Charles Floate mi -am dat seama O comandă pe care Google o poate utiliza A izbucni PBN:

Toate site -urile web care blochează roboții (Ahrefs este blocată prin excelență) fie manual, fie cu pluginuri ca Spyderspanker sau gratuit LinkPrivacy Ei lasă o amprentă evidentă în dosarul roboților. După cum puteți vedea, este foarte simplu să îl detectați și, de obicei, PBN -urile mari, de obicei, utilizează acest tip de blocaje pe site -urile lor web, astfel încât utilizatorii care urmăresc linkurile concurenților să nu urmărească sau să localizeze site -urile care fac parte dintr -unul sau altul PBN. Sunt înclinat să cred mai mult în această teorie decât în care sugerează că Google a dezvoltat un nou algoritm care detectează modele de legătură similare.

Rezultat? O modalitate foarte simplă de a ști ce site -uri web trebuie să monitorizeze (linkurile lor) pentru a detecta PBN CMS. La fel de ușor ca să punem 50 de semeni la lucru 12 ore pe zi și încărcați pentru noi toți.

Acesta poate fi Foarte conspirațiedar numerele coincid alarmant. Potrivit lui Charles Flarate, el a contactat mai mult de 50 de WebStersteri din grupul său de Facebook și din 95% au blocat roboți (Peste 60% au folosit SpyderSpanker).

Punct în favoare: Știm deja că nu ar trebui să folosim blocante de bots dacă avem propriul nostru PBN și să evităm legăturile care provin de la PBN care au puțin privat 😉

Pentru ceva Google este cel mai bun motor de căutare din lume …

Îl critic pe Google, dar îl ador cu adevărat și l -am apărat întotdeauna ca Regele Regilor. Nu sunt în stare să -mi imaginez cât de complicat trebuie să fie calibrarea unui algoritm fără a provoca efecte secundare grave și mă refer la legături automate de luptă fără a face rău celor care primesc Legături automate de concurență (SEO negativ). Cum să diferențiați/să nu penalizați pe cei care au spam -ul făcut de la ei înșiși de cei care au primit -o din competiție?

Este foarte complicat și gândirea la asta ne va face să vedem Cât de mare este algoritmul Google. Interesant este că cei care lucrăm cel mai mult predarea și învățarea suntem adesea cei mai urâți de urâții lașilor. În cazul meu, blogul meu nu este motorul meu economic, nu -mi plătesc facturile sau laptele fiului meu, dar există bloggeri de înaltă calitate, care trăiesc de pe blogul lor personal și primesc atacuri SEO negative fără niciun motiv (mai degrabă decât să ajute gratuit) și, în afară de a fi anecdotale, mi -ar plăcea foarte mult să văd unii dintre acei copii de **** în persoană care să -și dea fețele și să explice de ce să facă ceva

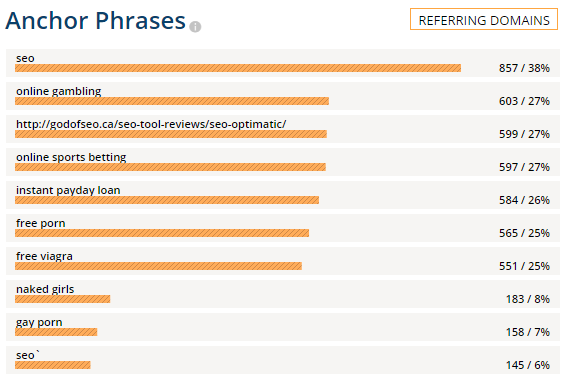

Din fericire Google este gata și SEO negativ este trecut prin BeiconDeci, să ne bucurăm de unele dintre atacurile pe care le am cunoștințe și sunt, cel puțin curioși:

Matthew Woodward

Charles Floate

(Godofseo.ca, persoana care a primit cel mai mult negativ în fața pământului)

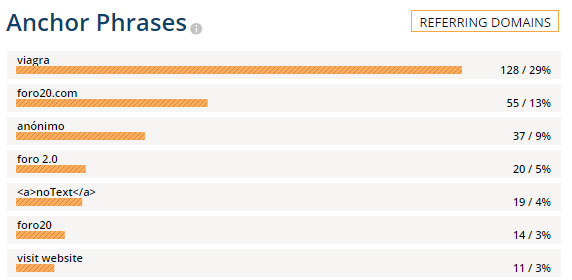

Forum20

Luis M. Villanueva (cu cât de buni sunt oamenii!)

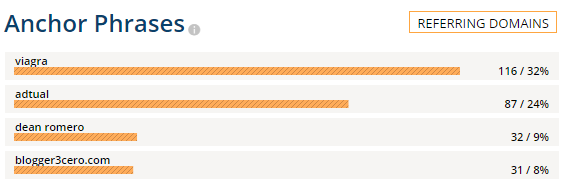

Dean Romero (o altă fisură care a contribuit foarte mult la SEO hispanic)

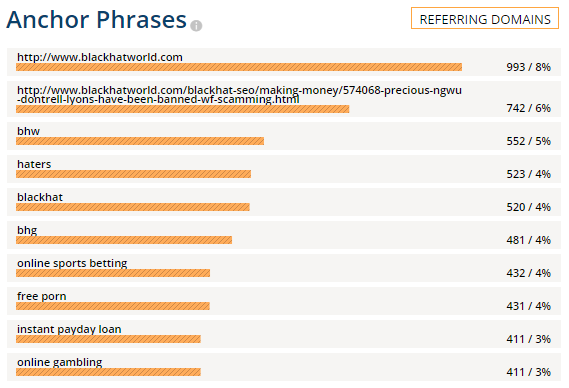

Blackhatworld (Uite, acest lucru nu mă surprinde atât de mult hahaha)

Și un server (se vede că cu mine sunt mai obsedate hehe)

Asta este totul! A fost o postare, așa că sunt sigur Îl veți împărtăși pe rețelele dvs. de socializare 😛 O îmbrățișare și ne vedem în continuare!